À mesure que les progrès en matière de robotique et d’intelligence artificielle se poursuivent, les efforts visant à rendre les robots moins effrayants et troublants et plus conviviaux et ressemblant à des humains sont un objectif convoité. créneau de développement. Aujourd’hui, des chercheurs financés par le gouvernement fédéral prétendent avoir créé un robot qui peut imiter les expressions faciales de la personne qu’il à qui il parle.

Dans un récemment article publié, des chercheurs travaillant grâce à une subvention de la National Science Foundation ont expliqué comment ils ont construit leur nouveau robot, « Emo », et les efforts qu’ils ont déployés. prises pour rendre la machine plus réactive aux interactions humaines. Au début de l’article, les chercheurs notent l’importance de l’interaction humaine. sourire dans le miroir social :

Peu de gestes sont plus attachants qu’un sourire. Mais lorsque deux personnes se sourient simultanément, l’effet est amplifié : non seulement le sentiment d’être mutuel, mais aussi le fait que les deux parties exécutent le sourire simultanément, elles sont probablement capables de déduire correctement l’état mental de chacun à l’avance.

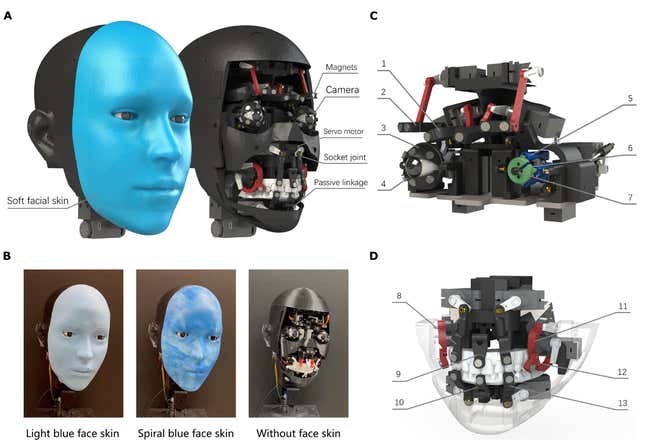

Le nouveau robot des chercheurs est un « robot facial anthropomorphe ». Ce n’est pas leur premier robot. Une itération précédente du robot a été surnommée « Eva. »Cependant, les chercheurs disent qu’Emo est nettement plus avancé qu’Eva.

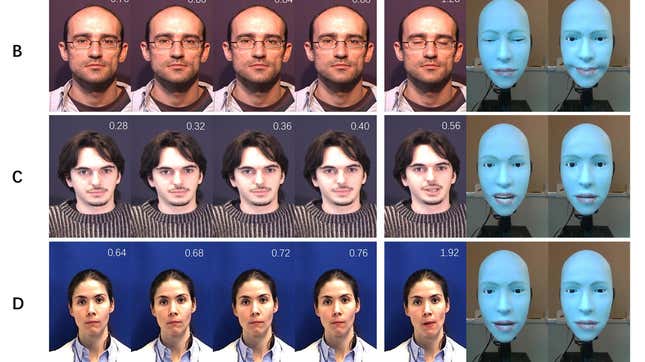

L’objectif avec Emo était de réaliser ce que les chercheurs appellent la « coexpression », ou l’émulation simultanée de l’expression faciale d’un humain. que les chercheurs ont développé un algorithme prédictif qui a été formé sur un grand ensemble de données vidéo d’humains faisant des expressions faciales. Les chercheurs affirment que l’algorithme qu’ils ont développé est capable de « prédire l’expression cible qu’une personne produira sur la base de changements initiaux et subtiles dans leur visage. » L’algorithme communique ensuite au matériel du robot quelle configuration faciale émuler en « temps réel », disent les chercheurs.

En fait, amener le robot à faire une expression faciale est une autre histoire. Les différentes configurations faciales du robot sont alimentées par 26 moteurs différents et 26 actionneurs. Les chercheurs affirment que la majorité des moteurs sont « distribués symétriquement », ce qui signifie qu’ils sont conçus pour créer des expressions symétriques, avec à l’exception de celui qui contrôle la mâchoire du robot. Trois moteurs contrôlent les mouvements du cou du robot. Les actionneurs, quant à eux, permettent création d’expressions plus asymétriques.

Emo est également équipé d’une « peau » en silicone interchangeable qui est attachée au visage du robot à l’aide de 30 aimants. Les chercheurs notent que cette peau peut "être remplacé par des designs alternatifs pour une apparence différente et pour l’entretien de la peau”, ce qui rend le visage personnalisable. Le robot a également des “yeux, " qui sont équipés de caméras RVB haute résolution. Ces caméras permettent à Emo de voir son participant à la conversation et d’émuler ainsi son expression faciale.

Dans le même temps, les chercheurs écrivent qu’ils déploient ce qu’ils appellent un « cadre d’apprentissage composé de deux réseaux neuronaux, l’un pour prédire les effets d’Emo. propre expression faciale (le modèle de soi) et une autre pour prédire l’expression faciale de l’interlocuteur (le modèle de l’interlocuteur). et le matériel ensemble, ce que vous obtenez est une machine qui peut faire des choses comme ceci :

Une version de cette histoire a été publiée à l’origine sur Gizmodo.

Ce contenu a été traduit automatiquement à partir du texte original. De légères différences résultant de la traduction automatique peuvent apparaître. Pour la version originale, cliquez ici.