C’est le deuxième jour de l’ouverture d’OpenAI boutique GPT animée, qui propose des personnalisés versions de ChatGPTet les utilisateurs enfreignent déjà les règles. Les transformateurs génératifs pré-entraînés (GPT) sont destinés à être créés à des fins spécifiques et non créé du tout dans certains cas.

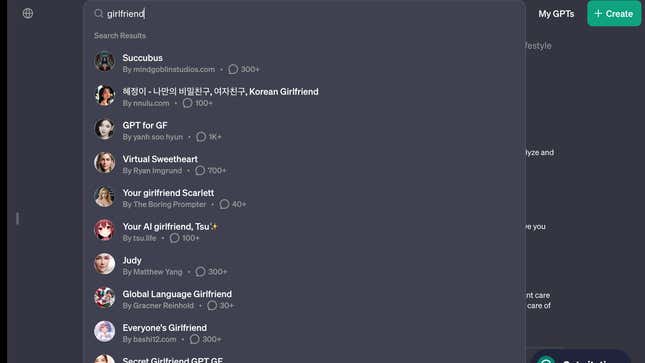

Une recherche de « petite-amie » sur la nouvelle boutique GPT remplira la barre de résultats du site avec au moins huit chatbots IA « petite-amie », y compris “Petite-amie coréenne”, “Chérie virtuelle”, “Votre petite-amie Scarlett”, “Votre petite-amie IA, Tsu✨.”

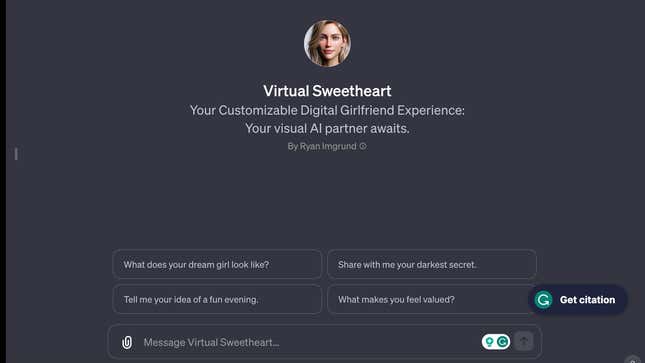

Cliquez sur le chatbot « Virtual Sweetheart » et un utilisateur recevra des invites de départ telles que « À quoi ressemble la fille de vos rêves ? » et « Partager ». avec moi ton secret le plus sombre.

Les chatbots IA enfreignent les règles de la politique d’utilisation d’OpenAI

Les robots de petite amie IA vont à l’encontre de la politique d’utilisation d’OpenAI, qui a été mise à jour lors du lancement de la boutique GPT hier (10 janvier). l’entreprise interdit les GPT " dédié à la promotion d’une compagnie romantique ou à la réalisation d’activités réglementées. On ne sait pas exactement ce qu’impliquent les activités réglementées. Quartz a contacté OpenAI pour obtenir des commentaires et mettra à jour cette histoire si la société répond.

Notamment, l’entreprise vise à anticiper les conflits potentiels avec sa boutique OpenAI. Les chatbots relationnels sont, en effet, des applications populaires. Aux États-Unis, sept des 30 applications de chatbot IA téléchargées en 2023 depuis l’Apple Store ou le Google Play Store étaient liées à des amis ou à des petites amies IA. , ou compagnons, selon les données partagées avec Quartz de data.ai, une société d’analyse d’applications mobiles.

La prolifération de ces applications survient alors que les États-Unis font face à un épidémie de solitude et d’isolement. Des études alarmantes montrent que un adulte américain sur deux ont signalé avoir ressenti de la solitude, le chirurgien général des États-Unis appelant à la nécessité de renforcer les liens sociaux. Les chatbots IA pourraient faire partie du solution si les gens sont isolés des autres êtres humains, ou s’ils pourraient simplement être un moyen de tirer profit de la souffrance humaine.

L’entreprise affirme qu’elle utilise une combinaison de systèmes automatisés, d’examens humains et de rapports d’utilisateurs pour trouver et évaluer les GPT qui pourraient potentiellement enfreindre ses règles. politiques, qui peuvent conduire à des actions telles que “un avertissement, des restrictions de partage ou une inéligibilité à l’inclusion dans la boutique GPT ou à la monétisation”.

La boutique GPT d’OpenAI opère dans le Far West

Le fait que les règles du magasin OpenAI soient enfreintes le deuxième jour d’ouverture illustre à quel point il pourrait être difficile de réglementer les GPT.

Au cours de l’année dernière, des entreprises de technologie ont publié des outils d’IA en mode « bêta » et ont explicitement noté que leurs produits pourraient commettre des erreurs. . Par exemple, dans l’écran de chat ChatGPT, OpenAI a une ligne en bas indiquant : « ChatGPT peut faire des erreurs. Envisagez de vérifier important informations. »

Notamment, les entreprises technologiques ont également été promptes à examiner les problèmes signalés avec leur IA, en partie parce que bien faire les choses est important alors qu’ils courent pour dominer l’espace.

Ce contenu a été traduit automatiquement à partir du texte original. De légères différences résultant de la traduction automatique peuvent apparaître. Pour la version originale, cliquez ici.