Nvidia est le Taylor Swift des entreprises technologiques.

C’est Clients de l’IA débourser 40 000 $ pour les puces avancées et attendent parfois des mois pour obtenir la technologie de l’entreprise, en restant loyal même lorsque des alternatives concurrentes font leur début. Cette dévotion vient du fait que Nvidia est le plus grand fabricant de puces d’IA jeu en ville. Mais il existe également des raisons techniques majeures qui incitent les utilisateurs à revenir.

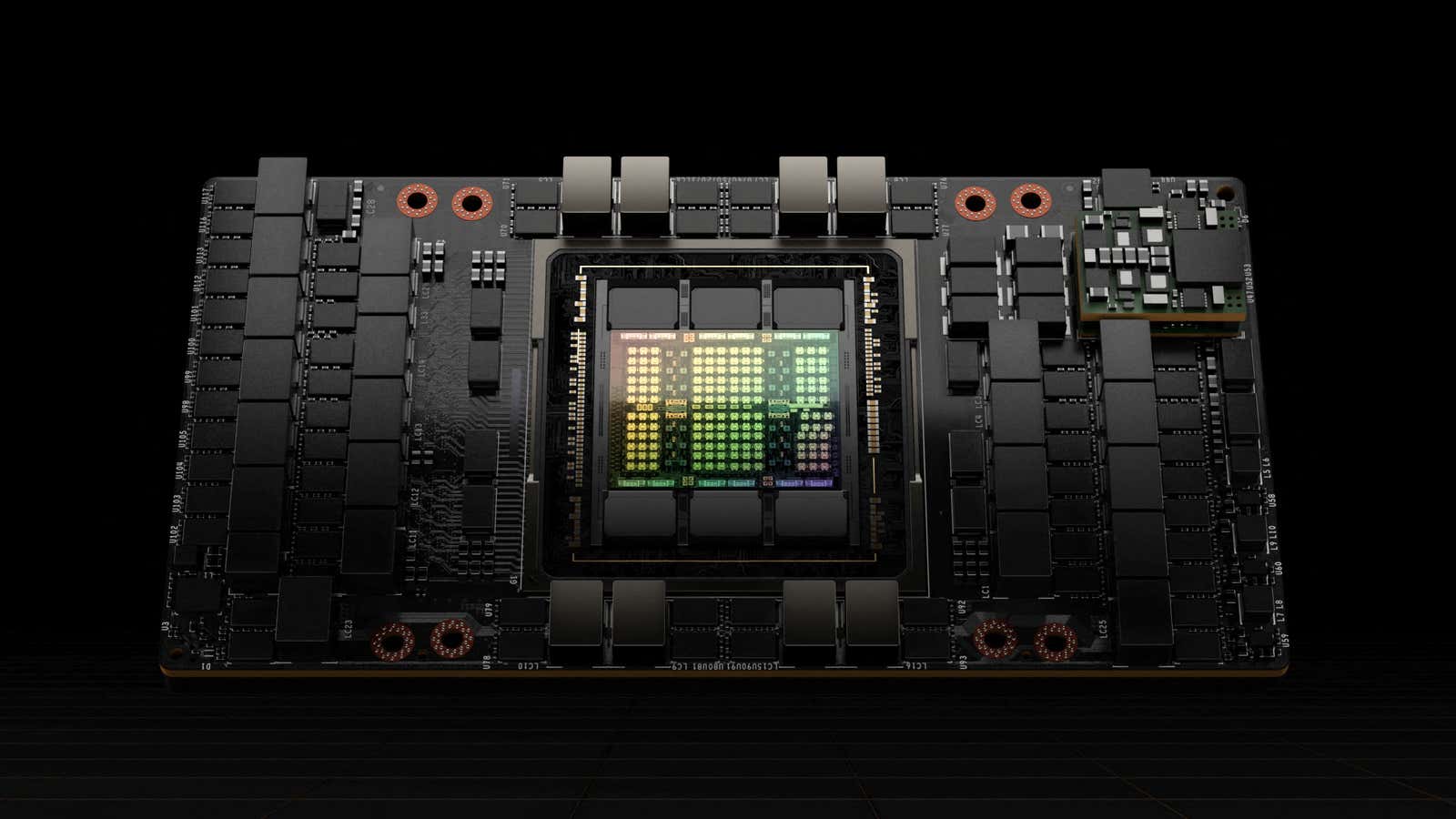

Par exemple, il n’est pas simple de remplacer une puce par une autre : les entreprises construisent leurs produits d’IA selon les spécifications de ces puces. Passer à une autre option peut signifier revenir en arrière et reconfigurer les modèles d’IA, une tâche longue et coûteuse. Ce n’est pas non plus facile Il est possible de mélanger et d’associer différents types de puces. Et ce n’est pas seulement une question de matériel : CUDA, le logiciel de Nvidia permettant de contrôler les puces d’IA appelées GPU, fonctionne très bien, a déclaré Ray Wang, PDG de Constellation Research, basé dans la Silicon Valley. Wang a ajouté que cela contribue à renforcer la domination de Nvidia sur le marché.

« Ce n’est pas comme s’il y avait un blocage », a-t-il déclaré. « C’est juste que personne n’a vraiment pris le temps de dire : « Hé, allons construire quelque chose de mieux. »

Cela pourrait changer. Au cours des deux dernières semaines, Les entreprises technologiques ont commencé à venir déjeuner chez Nvidia, avec parent Facebook Méta, Google alphabet parent, et DMLA toutes les puces nouvelles ou mises à jour. Autres y compris Microsoft et Amazone ont également fait des annonces récentes concernant des produits à base de chips locaux.

Tandis que Il est peu probable que Nvidia soit détrôné de sitôt, ces efforts et d’autres pourraient menacer l’entreprise part de marché estimée à 80 % en exploitant certaines des faiblesses du fabricant de puces électroniques, en tirant parti d’un écosystème en évolution, ou les deux.

Différentes puces sont plus efficaces pour différentes tâches d’IA, mais passer d’une option à l’autre est un casse-tête pour les développeurs. Cela peut même être difficile pour différents modèles de la même puce, a déclaré Wang. La création de logiciels capables de fonctionner correctement entre une variété de puces crée de nouvelles opportunités pour les concurrents, avec Wang pointant vers une API en tant que start-up travaillant déjà sur un produit comme celui-là.

« Les gens vont se rendre compte qu’ils ont parfois besoin de processeurs, parfois de GPU et parfois de TPU, et vous aurez des systèmes qui vous guideront réellement à travers ces trois éléments », a déclaré Wang, faisant référence aux unités centrales de traitement, aux unités de traitement graphique et aux unités de traitement tensoriel, trois types différents de puces d’IA.

En 2011, les capital-risqueurs Marc Andreessen a proclamé que les logiciels étaient en train de dévorer le monde. Cela est toujours vrai en 2024 en ce qui concerne les puces d’IA, qui sont de plus en plus portées par l’innovation logicielle. Le marché des puces d’IA connaît une évolution familière qui fait écho dans les télécommunications, dans le cadre de la période de développement des technologies de plusieurs composants matériels qui ont passé à des solutions logicielles intégrées, a déclaré Jonathan Rosenfeld, qui dirige le groupe FundamentalAI au MIT FutureTech.

« Si vous regardez les avancées réelles en matière de matériel, elles ne viennent pas de la loi de Moore ou de quelque chose de ce genre, même de loin », a déclaré Rosenfeld, qui est également cofondateur et directeur technique de la start-up spécialisée dans l’IA dans le domaine de la santé. somite.ai.

Cette évolution indique un avenir dans lequel les logiciels jouent un rôle essentiel dans l’optimisation des différentes plateformes matérielles, réduisant ainsi la dépendance à un fournisseur unique. Bien que CUDA de Nvidia soit un outil puissant au niveau de la puce unique, le passage à un paysage dépendant des logiciels requis par les très grands modèles qui couvrent de nombreux GPU ne profitera pas nécessairement à l’entreprise.

« Nous allons probablement assister à une consolidation », a déclaré Rosenfeld. « Il y a de nombreux entrants, beaucoup d’argent et certainement beaucoup d’optimisation qui peuvent se produire. »

Rosenfeld ne voit pas d’avenir sans Nvidia comme force majeure dans la formation de modèles d’IA comme ChatGPT. L’entraînement est la façon dont les modèles d’IA apprennent à effectuer des tâches, tandis que l’inférence consiste à utiliser ces connaissances pour effectuer des actions, comme répondre aux questions posées par les utilisateurs à un chatbot. Les besoins informatiques de ces deux étapes sont distincts, et bien que Nvidia soit bien adapté à la partie entraînement de l’équation, les GPU de l’entreprise ne sont pas tout à fait configurés pour l’inférence.

Malgré cela, l’inférence a été prise en compte environ 40 % des revenus du centre de données de l’entreprise au cours de l’année écoulée, Nvidia a déclaré dans son dernier rapport sur les résultats.

« Franchement, ils sont meilleurs en matière de formation », a déclaré Jonathan Ross, PDG et fondateur de Groq, une start-up spécialisée dans les puces d’IA. « Vous ne pouvez pas créer quelque chose qui soit meilleur dans les deux domaines. »

C’est dans la formation que vous dépensez de l’argent, et c’est dans l’inférence que vous gagnez de l’argent, a déclaré Ross. Mais les entreprises peuvent être surprises lorsqu’un modèle d’IA est mis en production et nécessite plus de puissance de calcul que prévu, ce qui réduit les bénéfices.

De plus, les GPU, la principale puce fabriquée par Nvidia, ne sont pas particulièrement rapides pour fournir des réponses aux chatbots. Bien que les développeurs ne remarqueront pas un léger décalage ou un léger retard au cours d’une formation d’un mois, les personnes qui utilisent des chatbots souhaitent des réponses aussi rapides que possible.

Ainsi, Ross, qui travaillait auparavant sur des puces chez Google, a lancé Groq pour construire des puces appelées unités de traitement du langage (LPU), qui sont conçues spécifiquement pour l’inférence. Un test tiers de Analyse artificielle Nous avons découvert que ChatGPT pouvait fonctionner plus de 13 fois plus vite s’il utilisait les puces Groq.

Ross ne considère pas Nvidia comme un concurrent, même s’il plaisante en disant que les clients se retrouvent souvent en tête de file pour obtenir des puces Nvidia après avoir acheté chez Groq. Il les considère plutôt comme des collègues dans le domaine, effectuant la formation tandis que Groq fait les inférences. En fait, Ross a déclaré que Groq pourrait aider Nvidia à vendre plus de puces.

« Plus les gens commenceront enfin à gagner de l’argent grâce à l’inférence », a-t-il déclaré, « plus ils dépenseront en formation. »

Ce contenu a été traduit automatiquement à partir du texte original. De légères différences résultant de la traduction automatique peuvent apparaître. Pour la version originale, cliquez ici.