Un juge de l’État de Washington a empêché que des preuves vidéo qui ont été « améliorées par l’IA » soient soumises dans le cadre d’un procès pour triple meurtre. bonne chose, étant donné que trop de gens semblent penser à appliquer un Filtre IA peut leur donner accès à des données visuelles secrètes.

Le juge Leroy McCullough dans le comté de King , Washington a écrit dans une nouvelle décision que la technologie de l’IA utilisait « des méthodes opaques pour représenter ce que le modèle de l’IA « pense » devrait être montré », selon un nouveau rapport de Actualités NBC Mardi. Et c’est un peu de clarté rafraîchissante sur ce qui se passe avec ces outils d’IA dans un monde de battage médiatique sur l’IA.

« Cette Cour estime que l’admission de ces preuves renforcées par Al conduirait à une confusion des questions et à une confusion des témoignages oculaires, “et pourrait conduire à un essai long au sein d’un essai sur le processus non évaluable par les pairs utilisé par le modèle d’IA”, McCullough a écrit.

L’affaire concerne Joshua Puloka, un homme de 46 ans accusé d’avoir tué trois personnes et d’en avoir blessé deux autres dans un bar juste à l’extérieur de Seattle. en 2021. Les avocats de Puloka voulaient présenter une vidéo de téléphone portable capturée par un spectateur et a été améliorée par l’IA, bien que on ne sommes pas clair ce qu’ils croient pourraient être tirés des images modifiées.

Les avocats de Puloka auraient fait appel à un « expert » en production vidéo créative qui n’avait jamais travaillé sur une affaire pénale auparavant pour « améliorer » la vidéo. L’outil d’IA que cet expert anonyme a utilisé a été développé par une société basée au Texas. Laboratoires de Topaze, qui est accessible à toute personne disposant d’une connexion Internet.

L’introduction d’outils d’imagerie basés sur l’IA ces dernières années a conduit à des malentendus généralisés sur ce qui est possible avec cette technologie. De nombreuses personnes pensent que faire passer une photo ou une vidéo via des upscalers IA peut vous donner une meilleure idée des informations visuelles qui sont déjà là. Mais en réalité , le logiciel d’IA ne fournit pas une image plus claire des informations présentes dans l’image. Le logiciel est simplement ajouter des informations qui n’existaient pas en premier lieu.

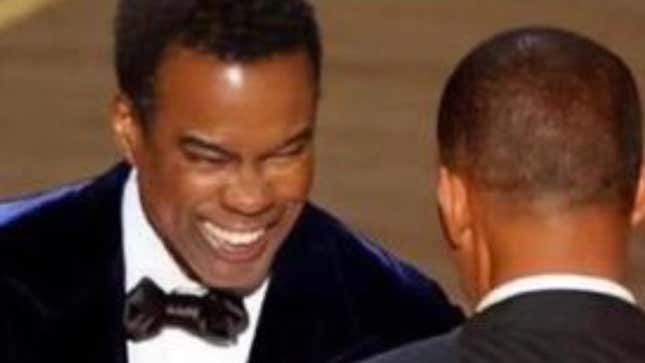

Par exemple, il y avait une théorie du complot largement répandue selon laquelle Chris Rock portait une sorte de masque facial lorsqu’il a été giflé par Will Smith. aux Oscars en 2022. La théorie a commencé parce que les gens ont commencé à exécuter des captures d’écran des upscalers d’images, croyant qu’ils pourraient obtenir un meilleur aperçu que se passait-il.

Mais ce n’est pas ce qui se produit lorsque vous exécutez des images grâce à l’amélioration de l’IA. Le programme informatique ajoute simplement plus d’informations dans le but de rendre l’image est plus nette, ce qui peut souvent déformer ce qui est réellement là. À l’aide du curseur ci-dessous, vous pouvez voir l’image pixellisée qui est devenue virale. avant que les gens ne commencent à l’alimenter via des programmes d’IA et à « découvrir » des choses qui n’étaient tout simplement pas là dans l’émission originale.

D’innombrables photos et vidéos haute résolution de l’incident montrent de manière concluante que Rock n’avait pas de tampon sur le visage. empêcher les gens de croire qu’ils pourraient voir quelque chose de caché à la vue de tous en « agrandissant » l’image à « 8K ».

L’essor des produits étiquetés IA a créé beaucoup de confusion parmi la personne moyenne quant à ce que ces outils peuvent réellement accomplir. des modèles de langage comme ChatGPT ont convaincu des personnes par ailleurs intelligentes que ces chatbots sont capables de raisonnements complexes alors que ce n’est tout simplement pas ce qui se passe sous le capot. Les LLM sont essentiellement, il s’agit simplement de prédire le prochain mot qu’il devrait cracher pour ressembler à un humain plausible. Mais parce qu’ils font un assez bon travail de ressemblant à des humains, de nombreux utilisateurs pensent qu’ils font quelque chose de plus sophistiqué qu’un tour de magie.

Et cela semble être la réalité avec laquelle nous allons vivre aussi longtemps que des milliards de dollars sont investis dans les entreprises d’IA.Beaucoup de gens qui devraient mieux savoir croient que quelque chose de profond se passe derrière le rideau et sont prompts à blâmer les « préjugés » et les garde-fous. être trop strict. Mais quand vous creusez un peu plus profondément, vous découvrez ces ce qu’on appelle des hallucinations ne sont pas une force mystérieuse exercée par des personnes trop éveillées, ou quoi que ce soit. Ils sont simplement un produit de cette technologie d’IA, non étant très bon dans son travail.

Heureusement, un juge de Washington a reconnu que cette technologie n’est pas capable de fournir une meilleure image. Même si nous ne doutons pas qu’il existe de nombreux juges aux États-Unis ont adhéré au battage médiatique de l’IA et ne comprennent pas les implications. Ce n’est qu’une question de temps avant que nous ayons une vidéo améliorée par l’IA utilisée au tribunal qui ne montre rien d’autre que des informations visuelles ajoutées bien après coup.

Une version de cet article paru à l’origine sur Gizmodo.

Ce contenu a été traduit automatiquement à partir du texte original. De légères différences résultant de la traduction automatique peuvent apparaître. Pour la version originale, cliquez ici.