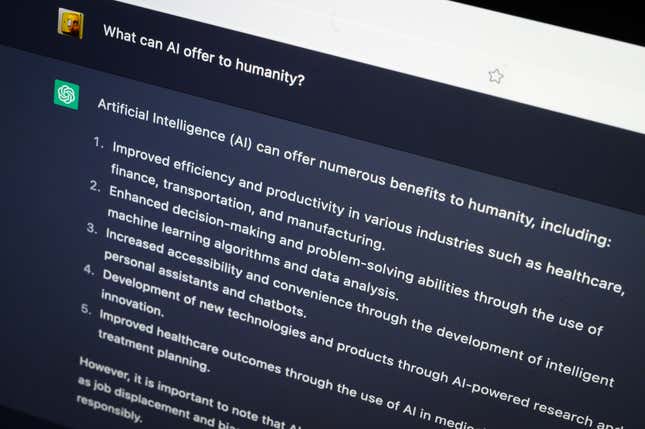

Il ne fait aucun doute que les sociétés d’IA de chatbots qui courent pour lancer leur lancement sont impressionnantes. peut coder, écrire des discours, réussir des examens, et même répondre à des questions médicales. Mais ce ne veut pas dire qu’il n’y a pas eu quelques trébuchements en cours de route, certains d’entre eux étant très médiatisés et embarrassants pour les entreprises derrière eux.

De la profession d’amour et du désir d’être humain à la jurisprudence hallucinante, consultez le diaporama ci-dessus pour découvrir certaines des plus grandes IA. Les erreurs des chatbots — jusqu’à présent.