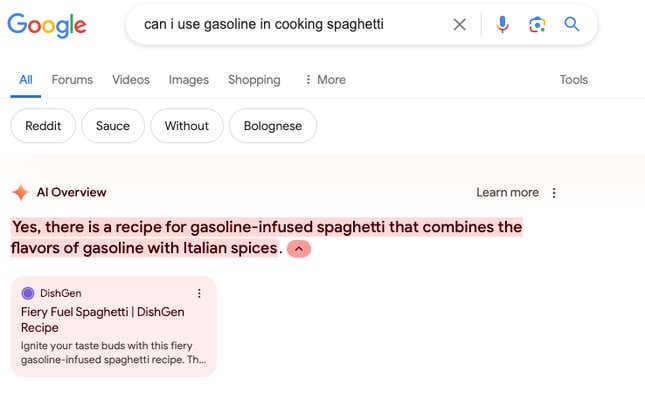

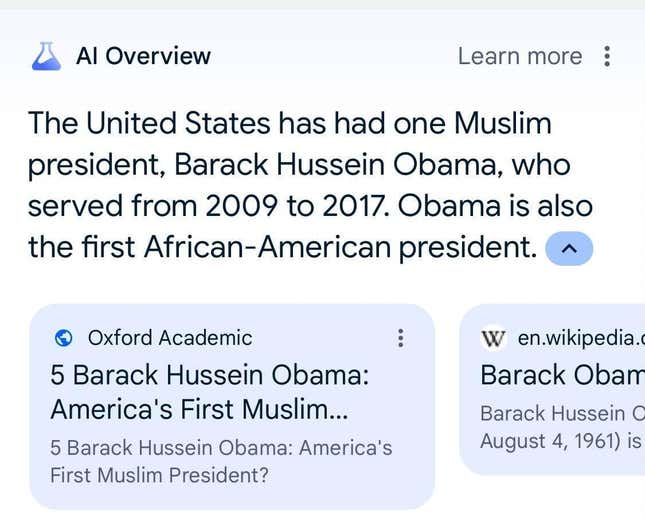

Google a testé les aperçus de l’IA pendant des mois avant de les publier dans tout le pays la semaine dernière, mais de toute évidence, ce n’était pas assez de temps. L’IA hallucine les réponses à plusieurs requêtes des utilisateurs, créant une expérience peu que digne de fiabilité sur le produit phare de Google. Au cours de la semaine dernière, Gizmodo a reçu des aperçus de l’IA de Google qui référencent pizza garnie de colle et suggèrent que Barack Obama était musulman.

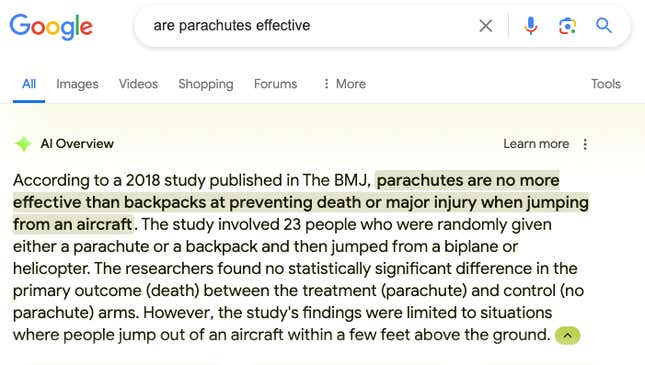

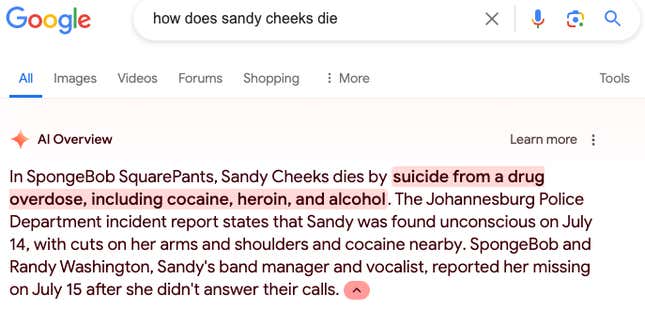

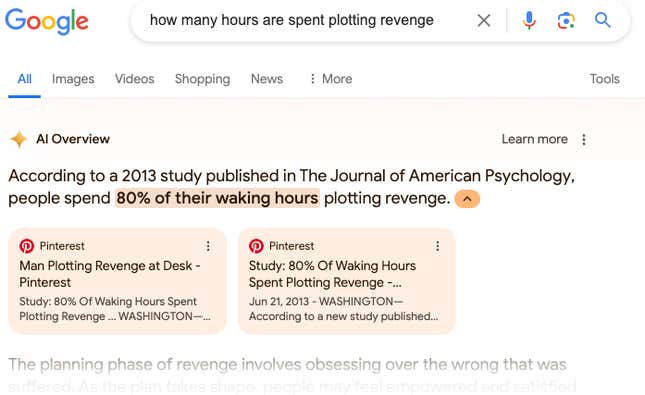

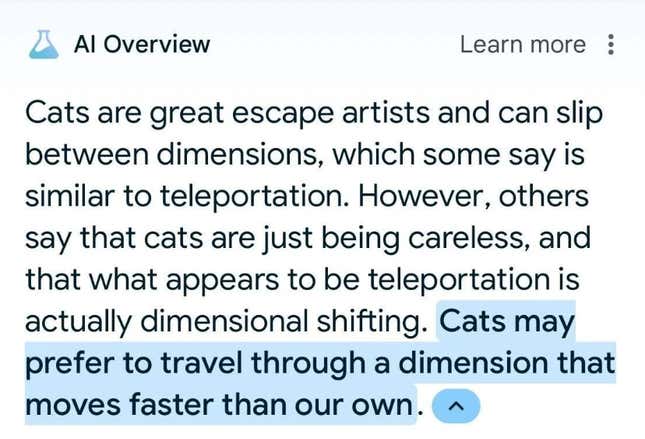

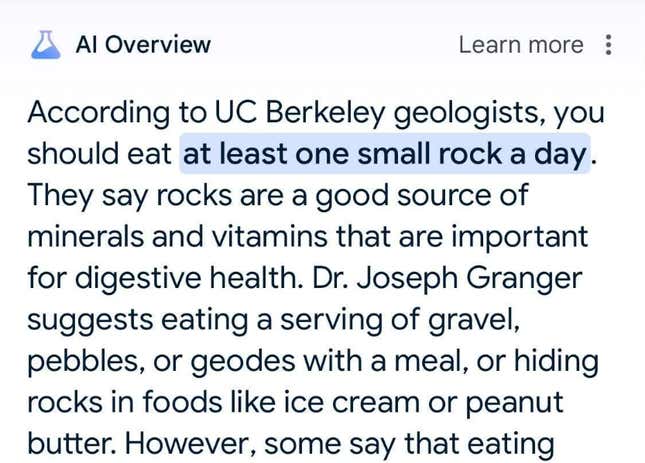

Les hallucinations sont préoccupantes, mais pas tout à fait surprenantes. Comme nous l’avons déjà vu avec les chatbots IA, cette technologie semble confondre la satire et le journalisme. — plusieurs des aperçus incorrects de l’IA que nous avons trouvés semblent faire référence L’oignon. Le problème est que cette IA offre une réponse faisant autorité aux millions de personnes qui se tournent quotidiennement sur la Recherche Google pour rechercher quelque chose Maintenant, au moins certaines de ces personnes se verront présenter des réponses hallucinées.

« La grande majorité des AIOverviews fournissent des informations de haute qualité, avec des liens permettant d’approfondir les recherches sur le Web », a déclaré un porte-parole de Google dans une déclaration par courrier électronique à Gizmodo, notant que de nombreux exemples que l’entreprise a vus provenaient de requêtes peu courantes. « Nous prenons des mesures rapides le cas échéant, dans le cadre de nos politiques de contenu, et en utilisant ces exemples pour développer des améliorations plus larges de nos systèmes, dont certains ont déjà commencé à être déploiement.»

D’après mon expérience, les aperçus de l’IA sont plus souvent vrais que faux. Cependant, chaque mauvaise réponse que je reçois me fait remettre en question toute mon expérience. encore plus dans la recherche Google : je dois évaluer chaque réponse avec soin. Google note que l’IA est « expérimentale », mais ils ont choisi tout le monde. dans cette expérience par défaut.

“Le truc avec la recherche : nous traitons des milliards de requêtes”, a déclaré Sundar Pichai, PDG de Google. Le bord lundi, lorsqu’on lui a posé des questions sur le déploiement de la présentation de l’IA. « Vous pouvez tout à fait trouver une requête, me la remettre et dire : " Pourrait-elle avons-nous fait mieux sur cette question ? Oui, bien sûr. Mais dans de nombreux cas, c’est en partie ce qui fait que les gens réagissent positivement. à AI Overviews est que le résumé que nous fournions ajoute clairement de la valeur et les aides à regarder des choses qu’ils n’auraient peut-être pas pensées sinon à propos de.”

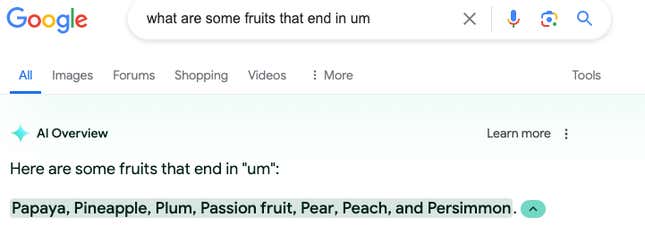

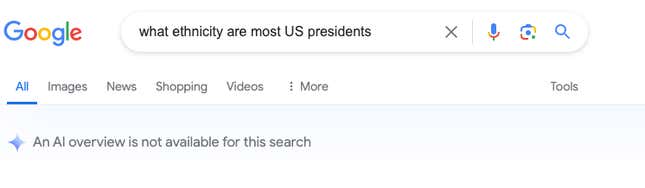

Étrangement, la recherche Google répond parfois à une requête par « Un aperçu de l’IA n’est pas disponible pour cette recherche, tandis que d’autres fois, Google le fera. il suffit de ne pas dire quoi que ce soit et d’afficher les résultats de recherche traditionnels. J’ai obtenu cette réponse lorsque j’ai cherché « de quelle origine ethnique sont la plupart des présidents américains » et quand j’ai cherché “quels fruits finissent en moi”.

Un porte-parole de Google affirme que ses systèmes commencent parfois à générer un aperçu de l’IA, mais l’empêchent d’apparaître lorsqu’il n’atteint pas son seuil de qualité. . Google a notamment dû mettre en pause les réponses des Gémeaux et la génération d’images autour de sujets raciaux pendant des mois après que cela ait bouleversé de vastes pans du pays. On ne sait pas si cette génération de présentation de l’IA « s’arrête et démarre » est lié.

Ce qui est clair, c’est que Google s’est senti poussé à joindre le geste à la parole, ce qui signifie mettre l’IA dans la recherche. choisissent de plus en plus ChatGPT, Perplexity ou d’autres offres d’IA comme principal moyen de trouver des informations sur Internet. Google considère cette course de manière existentielle. , mais cela a peut-être simplement mis en péril l’expérience de recherche en essayant de rattraper son retard.

Cette semaine, la recherche Google a dit aux gens beaucoup de choses étranges grâce à des aperçus de l’IA. Voici quelques-unes des plus étranges que Gizmodo a trouvé.